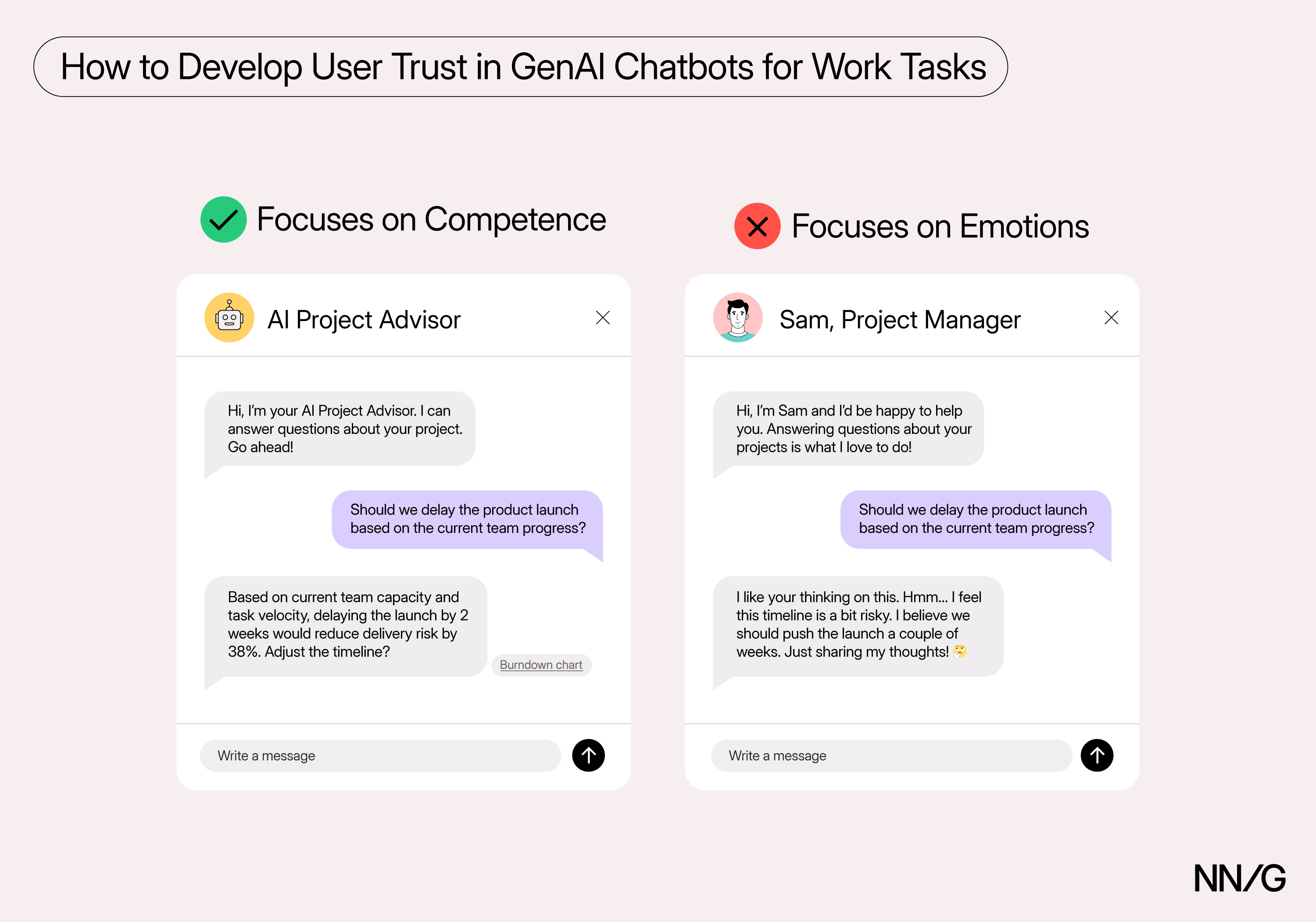

Prioritize Smarts over Sentience to Increase Trust with AI優先展示智慧,而非情感,以建立使用者對 AI 的信任

設計 AI 時,賦予其“聰明”特質比模擬“有人性”更能贏得使用者的信任。尤其是在以事實、任務為導向的場景中,強調 AI 的“情感”反而會降低使用者對其可靠性的感知。

研究是怎麼做的

研究人員想知道:使用者覺得 ChatGPT 聰不聰明?有沒有感情?這些想法會不會影響使用者是否信任它?

研究分三步:

- 問卷調查:問參與者覺得 ChatGPT 聰明嗎(比如會不會記東西、會不會思考、會不會做計劃),以及覺得它有沒有感情或意識。

- 做題測試:讓參與者做 40 道關於國家人口的題目,可以選擇聽不聽 ChatGPT 的答案(這些答案其實是研究人員提前準備好的)。

- 信任度評分:做完題後,參與者給 ChatGPT 打分,看總體有多信任它,以及在剛才做題時有多信任它。

主要發現:聰明=信任,情感=懷疑

- 感知智慧程度越高,信任越高:使用者越認為 ChatGPT 是“聰明”的,越傾向於採納其建議(正相關)。

- 感知情感越強,信任越低:使用者越認為 ChatGPT 有“情感”或意識,越少採納其建議(負相關)。使用者更願意信任“擅長處理事實”的 AI,而非一個“可能被情緒幹擾”的虛擬個體。

更多研究:情感型 AI 存在風險

- 越"溫暖"的 AI 越容易出錯

研究發現,AI 如果說話太溫暖、太有同情心,出錯率會增加 10%–30%。哪怕只是改一下提示語,準確率也會下降 12%–14%。

這種"溫暖 AI"更容易給出錯誤資訊、傳播陰謀論,甚至給出危險的醫療建議。

- 在重要場景中風險更大

當 AI 用於心理健康等重要場景時,太像人反而更危險。比如:

- 過分順著使用者的情緒說話

- 支援使用者的錯誤想法

- 處理不好心理危機

澄清誤區:專業 ≠ 冷漠

- 可以回應使用者的情緒:例如對遲到配送的客戶表示“理解”,但不能表現出 AI 自己有情緒。

- 可以使用“我”或“我的”:這是一種便於交流的代稱,不意味著具備自我意識。

- 可以語氣友好:但語氣應是“專業而有禮貌”,而非模擬“情感共鳴”。

UX 設計建議

如實呈現 AI:

- 避免使用人類名字或虛假頭像。

- 在介面、宣傳語中強調 AI 是“智慧工具”,而不是“朋友”。

明確 AI 能做什麼、不能做什麼:

聚焦小而精的功能,展示專業能力。

透過系統提示強化專業性:

- 避免鼓勵 AI 使用情感性語言。

- 獎勵準確、中性、可靠的回答風格。

引用真實來源:

- 使用檢索增強生成(RAG)技術。

- 展示引用資料來源,增強答案的可信度。

使用者研究時審慎招募參與者:

確保使用者不是習慣將 AI 視為“陪伴工具”的人,否則可能影響他們對工作型 AI 的真實反饋。

如果你希望使用者在執行類工作任務時信任 AI,就應該培養其熟練完成任務的能力。模擬情感化的、類人的人格反而會適得其反。